一、痛点导入:为什么很多 AI 客服看起来很“智能”,但用起来是“人工智障”

不少企业在推动 AI 客服时,初衷是降本增效、提升服务体验,但项目上线后却没达到预期。正如某篇分析指出,即使 AI 意图识别准确率很高,如果知识库设计不合理或关键场景覆盖不足,问题解决率仍可能非常低。

具体来看,这种落差往往源于三个致命错误:

(1)致命错误一:目标模糊 + 预期不切实际

很多 AI 客服项目没有明确的、量化的业务目标。公司希望“提升客户体验”、“减少客服成本”,但具体是要缩短平均响应时间?减少人工客服工单?还是提升首次解决率?如果目标不明确,技术再先进也难以衡量成功。正如业内建议:AI 项目应该设定具体指标,例如“减少客服平均解决时间 30%”“将重复基础问题人工介入率下降 50%”。

此外,过高的预期还会带来管理风险。领导层常将 AI 视为 “魔杖”,期望它可以立刻完全替代人工客服、解决所有问题 。这种期望如果不被合理校准,在项目早期就容易出现失望、资源撤回。

(2)致命错误二:数据质量差 + 系统孤岛严重

AI 客服的核心驱动力是数据。但很多企业忽视数据质量与整合能力的重要性。具体表现在:

- 数据质量问题:训练模型用的数据可能是不完整、过时、不准确的。例如,旧客服对话记录、陈旧 FAQ、散落在多个系统中的文档等。低质量数据会严重拖累 AI 的表现。

- 数据孤岛与系统割裂:AI 客服系统往往需要和 CRM、知识库、工单系统等进行深度集成。如果接口不兼容、数据字段映射失败,AI 无法获得完整上下文。现实中,这种集成失败是常见误区之一。

- 基础设施落后:有些公司没准备好支持 AI 的基础架构,比如实时数据处理能力、弹性扩展能力不足,这让 AI 系统难以在真实业务场景下稳定运行。

因此,光有一个“聪明”的对话模型还不够——没有优质数据加持,它很难真正解决用户问题。

(3)致命错误三:忽视运营与变更管理 — 把 AI 当一次性项目,而不是持续产品

许多 AI 客服项目失败,是因为被当作一个技术项目来对待,而不是长期运营的产品。具体体现在:

- 测试和验证不充分。有些团队在 POC(概念验证)阶段表现不错,但没有做足够真实场景下的压力测试与用户验证。这样上线后在真实业务中出错、用户不接受的风险就大。

- 人机协作机制不完善。AI 无法处理所有场景,尤其是复杂或异常问题。如果没有设计好 “误答时转人工” 或 “AI 低置信度时退回人工” 的机制,用户体验就会崩塌。Reddit 上有用户吐槽:“机器人随便猜测也回答,但没有 fallback 规则。” > “The lack of a fallback always kills trust … users don’t trust ai outputs”

- 没有持续更新与迭代。知识库更新慢、AI 不进化,会随着业务变化变得落后。很多企业上线后没建立训练师团队,也没设机制持续优化,这使得 AI 客服“上线是高潮,之后很快降温”。

- 组织变更管理弱。AI 客服的落地还需要跨部门协作:技术团队、客服团队、业务部门都要参与。如果忽视变更管理(培训、流程重塑、角色分配),员工抵触、高层预期落差都容易导致项目失败。 +1

二、如何避免这些致命错误:实操建议

为了规避上述问题,企业在启动 AI 客服项目时,可以采取以下策略:

1. 明确 KPI,量化目标

- 在启动阶段就和业务部门共同梳理核心指标(如回答率、解决率、转人工率、CSAT 等)

- 建立阶段性里程碑(POC → Beta test → 全量上线)

- 设定预期范围,并校准领导层对 AI 能力的理解(避免“AI万能”幻想)

2. 夯实数据基础

- 做数据质量审查:识别旧、过时、重复、错误的数据。

- 构建跨系统数据集成策略:制定统一数据标准、打通 CRM、工单、知识库等。

- 预先评估基础设施能力:云或本地是否支持高并发、实时访问、弹性伸缩。

3. 构建持续运营机制

- 设立 AI 训练师 / 内容运营团队,持续审校 AI 回答、更新知识库。

- 设计清晰的转人工机制(fallback 规则):AI 回答不确定 / 用户体验不好时极速转人工。

- 进行真实场景压力测试:上线前做负载、并发、用户行为模拟;上线后持续监控。

- 推进变更管理:培训客服、业务团队;明确责任人;定期回顾和调整。

三、趋势与展望

随着企业对 AI 客服的期待越来越高,这类失败案例也提醒我们:AI 不是点火即可成功的魔法。未来趋势上,有几个方向值得关注:

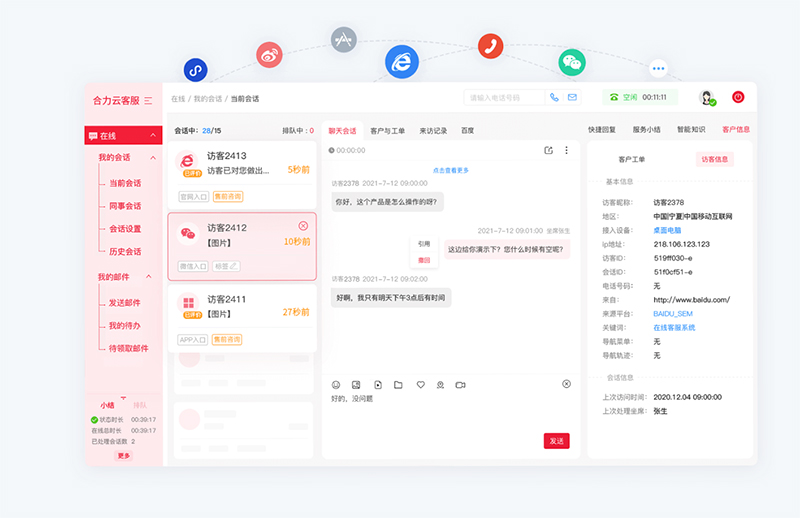

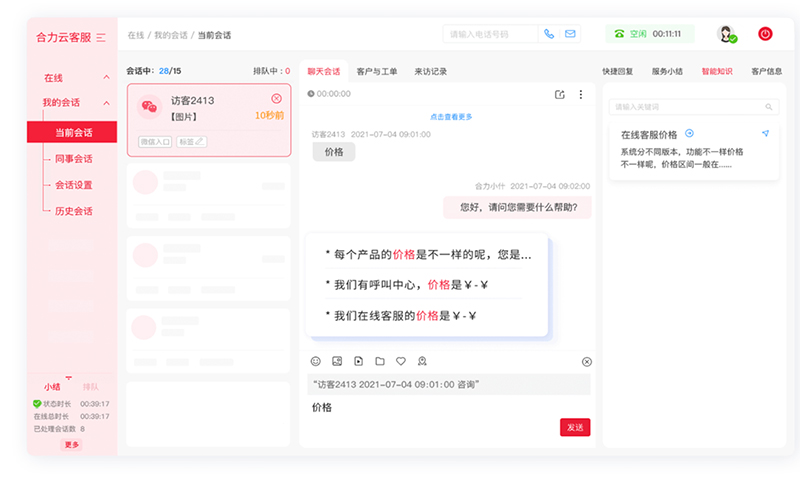

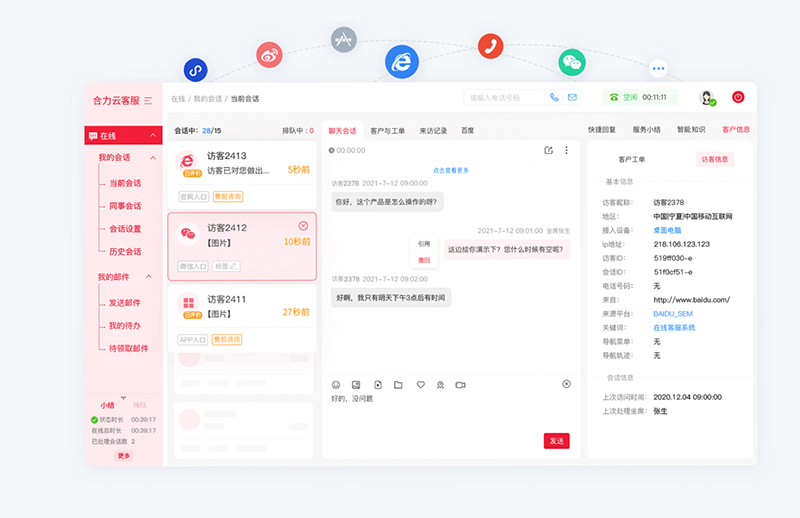

- 平台化 + 多 Agent 协同

企业会更加倾向于构建 AI “客服员工”体系,而不是单一对话机器人。多智能体(Agent)协作可以处理更复杂场景,比如亿捷云客服MPaaS平台,提升应答能力和灵活性。

- 自动化持续学习

AI 客服系统将更依赖持续学习机制。通过用户反馈、误答日志、业务更新,系统定期或实时调整和优化。

- 可解释性与合规性增强

随着法规、用户隐私意识提高,“可解释 AI”在客服系统中将更加重要。企业需要可审计、可追溯的决策机制。

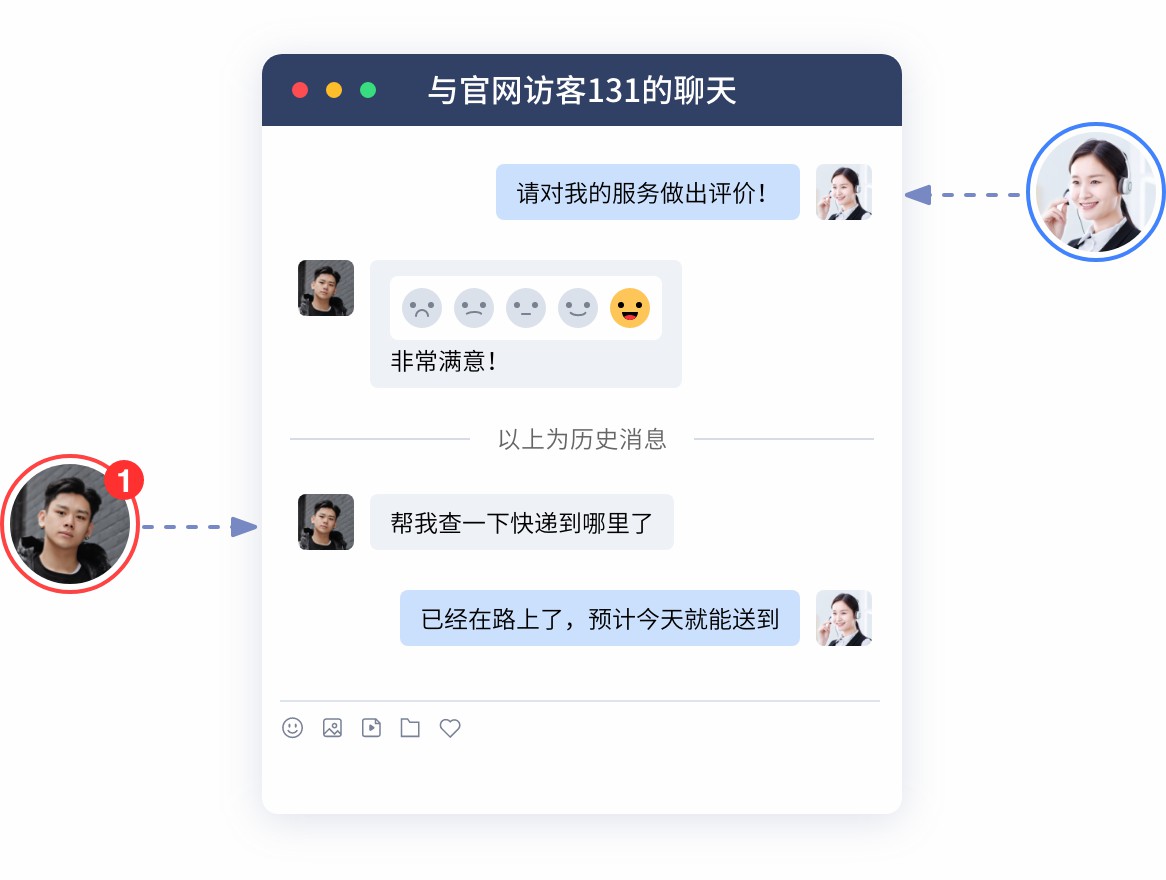

- 人机混合服务成为常态

AI 不会完全替代人工客服,而是与人工客服形成协作。复杂问题、关键信用判断、情绪敏感场景继续由人工处理。

- ROI 驱动下的精细化落地

企业更关注 AI 客服带来的真实业务价值(节省人工成本、提高客户满意度、减少误工单),因此项目不会只停留在技术试验阶段,而是纳入长期运营视角。

四、FAQ(常见问答)

Q1:AI 客服项目启动前,如何设定合理预期?

A:启动前需要与业务方共同讨论、明确落地的核心 KPI(如首次解决率、人工客服转接率、用户满意度等),并制定阶段性目标。建议进行 POC 阶段检验,避免一开始就设定过高期望。

Q2:数据质量差怎么办?公司属于多系统割裂、数据孤岛严重。

A:可以先开展数据评估与清洗工作,识别关键知识库、工单、CRM 等核心数据源;建立统一的数据标准和映射机制;必要时引入 ETL 或 MDM(主数据管理)平台来打通系统。

Q3:AI 回答不准怎么办?用户经常抱怨答非所问。

A:建立 fallback 机制 — 当 AI 置信度低时自动转人工;同时设置训练师团队定期审查 AI 回答、纠错、补充知识库,保持系统不断迭代。

Q4:项目上线后运营成本太高?

A:确实,AI 客服不是一次性项目。建议组建专门运营团队(AI 训练师、内容编辑、客服专家),持续维护知识库、监控对话质量。同时,可以和核心业务部门合作,定期评估 ROI,看是否通过节省人工、提高效率实现回报。

Q5:用户信任问题?有用户觉得机器人回答生硬、不可信。

A:信任问题可以通过多方面缓解:明确告知用户是 AI 回答;增加可解释性机制;让 AI 在不确定时明确表示“我不确定 /我不懂”,并转人工;加强语气设计,使对话更人性化。

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690