在过去的一年里,企业级 AI 的落地经历了一场从“盲目狂热”到“理性回归”的洗礼。

虽然大语言模型(LLM)展现出了惊人的对话能力,但在客服、咨询等严肃业务场景中,企业管理者发现了一个尴尬的现实:AI 越博学,似乎越容易“一本正经地胡说八道”。 这种被称为“AI 幻觉”的现象,不仅会误导客户,更可能给企业带来合规风险与品牌信任危机。

许多企业试图通过更换更昂贵的模型来解决这一问题,但往往收效甚微。本文的核心观点在于:企业级 AI 的幻觉问题,本质上不是一个模型技术问题,而是一个严峻的“知识与流程治理”问题。

一、 信任隐忧:当通识天才遇到企业“红线”

Gartner 在其最新的预测中指出,到 2025 年,至少 30% 的生成式 AI 项目将因数据质量差、风险控制不足或业务价值不明确而在验证阶段后被废弃。

对于企业客服系统而言,挑战尤为尖锐。通用的 ChatGPT 或文心一言等模型,虽然读过“万卷书”,但它们并不了解您企业的最新退换货政策、昨日更新的促销活动或特定的售后流程。

当用户询问一个模型“不知道”但又“觉得应该知道”的问题时,基于概率预测的 LLM 往往会选择编造一个看起来合理的答案,而不是承认“我不知道”。在闲聊场景下,这或许是“创造力”;但在涉及报价、条款或售后的企业服务场景中,这就是不可容忍的“事故”。

二、 溯源:为什么通用大模型不懂企业的“规矩”?

要治理幻觉,首先要理解其成因。大语言模型的底层逻辑是“基于概率的文字接龙”。它并不像数据库那样存储确定的“事实”,而是存储了词与词之间的关联概率。

因此,企业直接使用裸模型做客服,面临着两重天然的场景冲突:

1. 模糊 vs 精准:通用模型追求回答的丰富度与流畅性,而企业服务追求答案的唯一性与准确性。

2. 黑盒 vs 溯源:模型生成的答案往往无法找到确切出处,而企业客服要求每一句回答(特别是涉及资金与法律的回答)都必须“有据可查”。

麦肯锡在《The state of AI in early 2024》报告中指出,“不准确性”是企业采用生成式 AI 时面临的首要风险,且这一风险的关注度在过去一年中显著上升。这表明,单纯依赖模型自身的能力进化,短期内无法满足企业级的严谨性要求。

三、 破局:从“喂数据”到“治理知识”的范式转变

为了解决幻觉问题,RAG(检索增强生成) 技术成为了行业共识。简单来说,RAG 就是给 AI 发一本“开卷考试”的参考书(企业知识库)。AI 在回答问题前,必须先去书里查阅资料,然后基于查到的资料生成答案。

然而,技术只是骨架,“知识治理”才是血肉。很多企业部署了 RAG 系统后效果依然不佳,原因在于其知识库里充满了“垃圾数据”。

1. 知识资产的结构化重塑

传统的企业文档(Word、PDF)往往包含大量的噪音(页眉、页脚、图片)。如果直接把这些文件“丢”给 AI,AI 检索到的可能是错误的片段。

- 非结构化数据结构化:必须对文档进行清洗、切片,将长文档拆解为独立的、语义完整的知识点。

- QA 对拆解:将复杂的业务逻辑直接改写为“问题-答案”对,是最直接提升 AI 准确率的手段。

2. 检索精度的流程优化

RAG 的核心逻辑是“检索 + 生成”。如果检索到了错误的信息,生成得再好也是错的。

- 混合检索策略:成熟的系统不会只依赖向量检索(语义相似度),还会引入传统的关键词检索(精确匹配),以确保专有名词(如产品型号、错误代码)的绝对命中。

四、 立规:构建“人机协同”的防御性流程

技术治理之外,流程治理同样关键。AI 不应被视为一个“全自动”的黑盒,而应被纳入企业的管理流程中。

1. 提示词工程的“人设约束”

在系统层面(System Prompt)必须为 AI 设定严格的边界。例如:

“你是一名专业的客服顾问。请仅依据参考文档中的内容回答用户问题。如果参考文档中没有答案,请明确回答‘抱歉,我暂时无法回答该问题,请转人工服务’,严禁编造信息。”

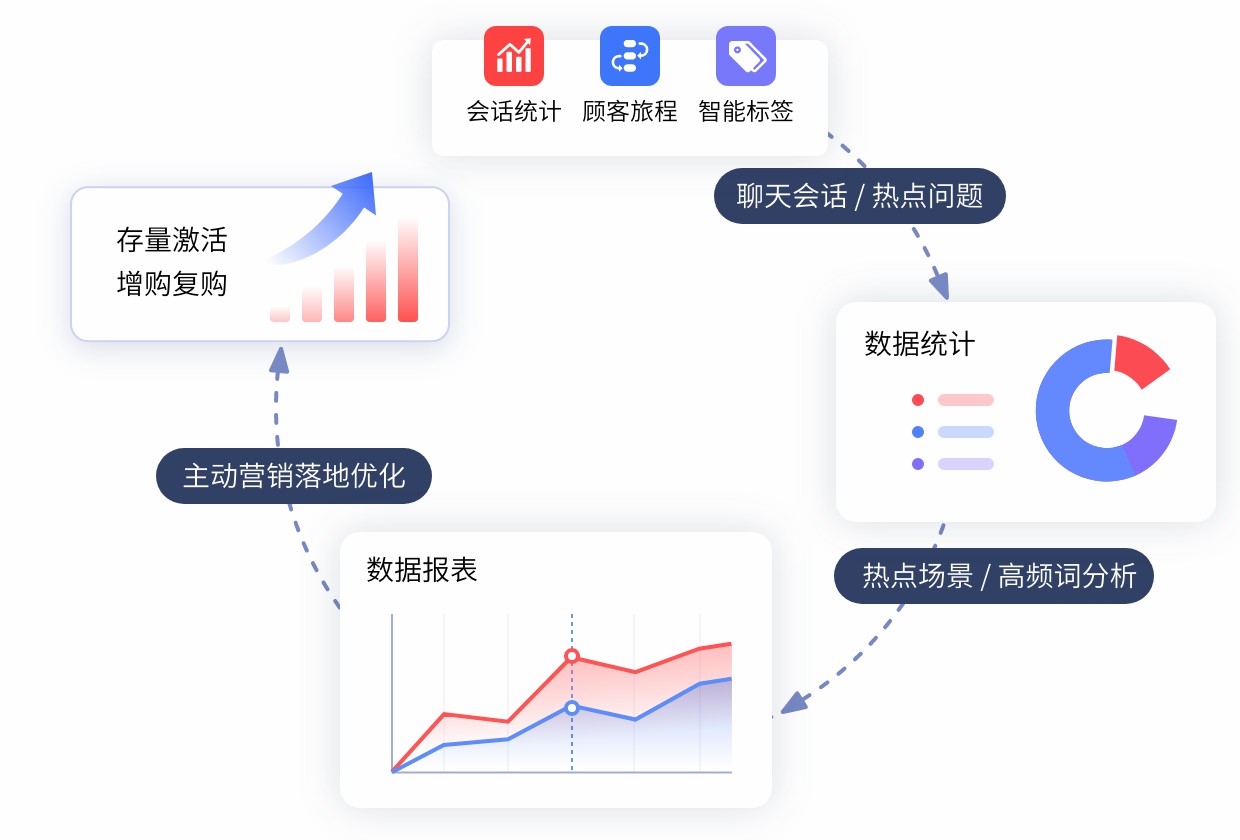

2. HITL反馈闭环

即使是最完美的系统也会出错。企业需要建立Bad Case(坏案例)修复机制:

- 角色转变:资深客服人员的角色将从“接线员”转变为“知识训练师”。

- 实时修正:当发现 AI 回答错误时,能在后台一键修正关联的知识点,确保下一次回答正确。这种“即时纠错”的能力,是区分玩具级 AI 与企业级 AI 的分水岭。

五、 落地验证:一个“言必有据”的智能客服架构标准

综上所述,一个成熟的、低幻觉的企业级 AI 客服系统,应当具备以下三个标准特征:

1. 引用溯源:AI 的每一次回答,文末都能列出“参考资料来源”,点击即可跳转至原始文档,让答案可验证。

2. 知识鲜活度:知识库支持秒级更新,业务变更后,AI 能即刻掌握新规。

3. 回答克制性:在置信度低时,主动示弱或转人工,而非强行作答。

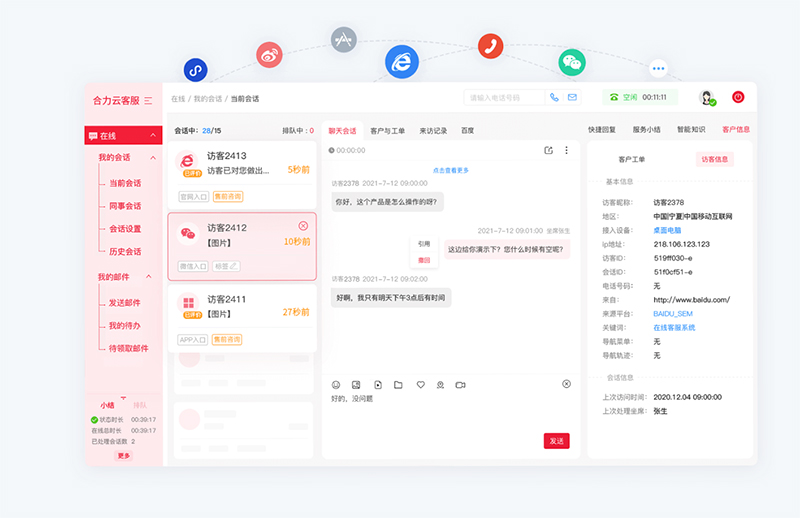

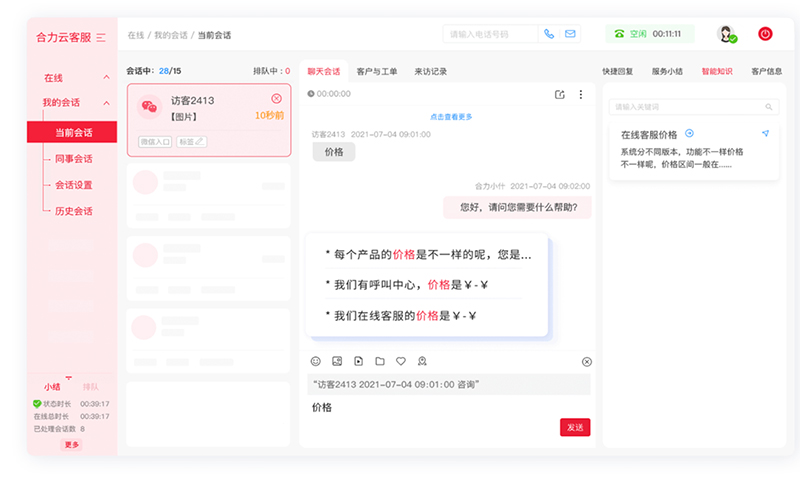

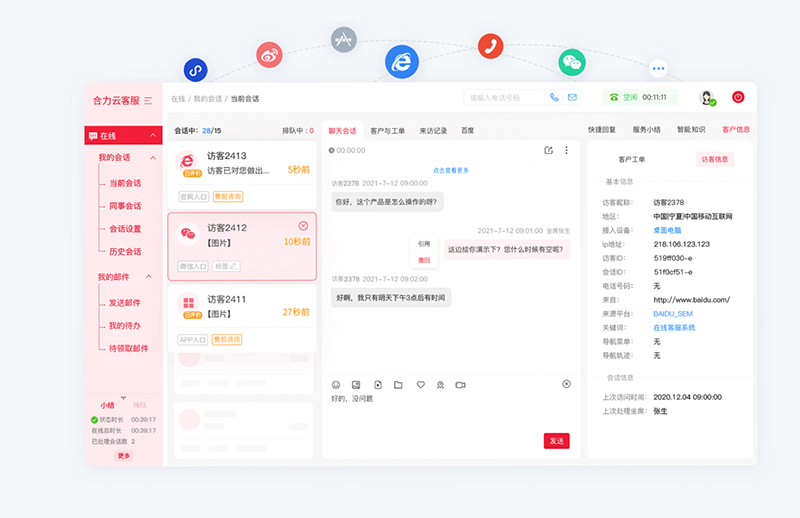

在实际的行业落地中,我们看到许多深耕客户联络领域的服务商正在践行这一路径。例如 亿捷云在其智能化解决方案中,不仅仅提供大模型接口,更着重于构建一套完整的知识库运营与管理组件。通过将通用大模型与企业私有知识库深度解耦又紧密协同,帮助企业在保留大模型理解能力的同时,利用外挂知识库这一“紧箍咒”,有效规避了幻觉风险,实现了客服回答的精准可控。

六、 结语

AI 不会取代流程,而是呼唤更严谨的流程。

对于企业管理者而言,消除 AI 幻觉的战役,实际上是一场企业数字化资产的治理战役。只有做好了枯燥的知识清洗与流程规范,企业才能真正享受 AI 带来的效率红利,让智能客服从“那个聪明的胡说者”变成“那个言必有据的金牌顾问”。

资料来源

1. Gartner: Gartner Predicts 30% of GenAI Projects Will Be Abandoned After Proof of Concept by End of 2025 (2024).

2. McKinsey & Company: The state of AI in early 2024: Gen AI adoption spikes and starts to generate value (May 2024).

3. IDC: Future of Intelligence: Trust and Governance in the Era of GenAI (2024).

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690