在政务服务领域,尤其是“惠企政策兑现”这一场景下,大模型(LLM)面临着比商业领域严苛百倍的容错标准。当一家企业询问:“我的条件能不能申请50万元的技术改造补贴?”

- 在电商客服场景,答错可能只是一张优惠券的赔偿;

- 在政务场景,一个错误的“能”,可能引发企业数万元的无效投入,进而演变为行政投诉、法律纠纷,甚至损害政府公信力。

“准确性”,是政务大模型落地的第一道坎,也是唯一的生死线。

许多管理者困惑:“我们已经把所有的红头文件都喂给AI了,为什么它还是会张冠李戴,甚至编造不存在的政策条款?”

本文将剥开技术外衣,直面这一核心痛点,并给出建立“确定性防线”的实操路径。

一、 风险根源:大模型是在玩“概率接龙”,而非“真理检索”

要解决问题,首先要祛魅。我们需要明白,目前市面上所有的大语言模型(无论它是GPT-4还是国产顶尖模型),其底层逻辑都不是像数据库那样“存储并调取真相”,而是基于概率预测“下一个字是什么”。

这就是“概率接龙”原理。

当用户问及某项政策时,模型并非在查找法条,而是在利用它庞大的语料库经验,拼接出一句看起来最通顺的话。这就导致了两类高频风险:

1. 数字张冠李戴: 在模型的训练数据中,“高新技术企业”常与“补贴20万”、“补贴50万”、“减免15%所得税”等词汇高频共现。当模型生成答案时,它极易将A政策的申报条件(如:营收超2000万),嫁接到B政策的补贴金额上。虽然句子通顺、逻辑自洽,但关键数据完全错误。

2. 失效政策“复活”: 如果一份2019年的文件在互联网上传播极广(训练权重高),而2023年的废止通知传播度低,模型极有可能无视时效,自信满满地引用那份已经作废的文件来解答当下的问题。

在没有强约束的情况下,大模型是天生的“幻想家”,而非严谨的“公务员”。

二、 为什么普通的“外挂知识库”(RAG)防不住?

为了解决幻觉,目前业界通用的做法是使用 RAG(检索增强生成)技术,即:先从知识库里搜出相关文件,再让AI总结。

但这在复杂的政务场景中,往往出现“补丁困境”。

典型场景:

- 主文件(1月发布): 《关于支持中小企业数字化转型的若干措施》,规定“给予软件投入30%的补贴”。

- 补充通知(3月发布): 增加限制条件“申请企业上一年度纳税额需不低于50万元”。

- 修订函(6月发布): 将补贴比例调整为“最高不超过20%”。

当企业询问补贴标准时,普通的检索技术往往只抓取到相关度最高、篇幅最长的主文件。AI基于主文件完美地回答了“30%补贴”,却完全遗漏了后续的“补丁”和“修订”。

这种“片面的准确”,在政务服务中等同于误导。仅仅把文件堆进数据库,不做精细化的时序与逻辑关联,依然无法建立防线。

三、 核心方案:构建“多维确定性防线”

要在概率性的机制中建立确定性,必须引入严格的工程约束。我们建议政务大模型项目必须落实以下三层防线:

1. 第一道防线:强制引用溯源 ——“无出处,不生成”

这是最核心的规则。所有的回答,必须能够精准定位到具体文件的具体条款。

- 技术实现:要求模型在生成的每一句话后面,必须标注【来源:XX文件 第X条】。

- 前端展示:用户点击脚注,能够直接弹窗展示原文片段。这不仅是增强可信度,更是将解释权归还给文件本身,实现免责。

- 效果对比:数据显示,开启“强制引用模式”后,模型的自由发挥空间被压缩,事实性错误的发生率通常可降低 85% 以上。

2. 第二道防线:角色定位——是“翻译官”,不是“判官”

很多项目失败,是因为让AI做了它不该做的事——资格裁定。

- 错误做法:AI直接告诉企业“您符合条件,可以领钱”。

- 正确做法:AI的角色是“翻译官”。它应该说:“根据《XX文件》,申请该项补贴需要满足以下A、B、C三个条件,请您核对自身情况。”

- 原理模型:将决策权留给企业和办事大厅,AI只负责将晦涩的“法言法语”翻译成易懂的“人话”,绝不逾越行政审批的红线。

3. 第三道防线:中间层“事实核查器”

在AI生成答案后,输出给用户前,增加一道自动化的“Fact Check”程序。

- 该程序会反向比对AI生成的答案中的关键实体(金额、时间、门槛)与检索到的原文是否一致。如果不一致,系统自动拦截该回答,并转为人工服务。

四、 兜底保障:敢于承认“我不知道”

在政务服务中,“不回答”的价值远高于“乱回答”。许多客服负责人陷入了“过度服务陷阱”,要求机器人有问必答。这在闲聊场景是优点,但在政策解读中是灾难。

我们建议设定严格的“拒识阈值”:

- 当模型对检索结果的匹配度低于 0.85(举例),或者对生成答案的置信度不足时,严禁模型强行拼凑答案。

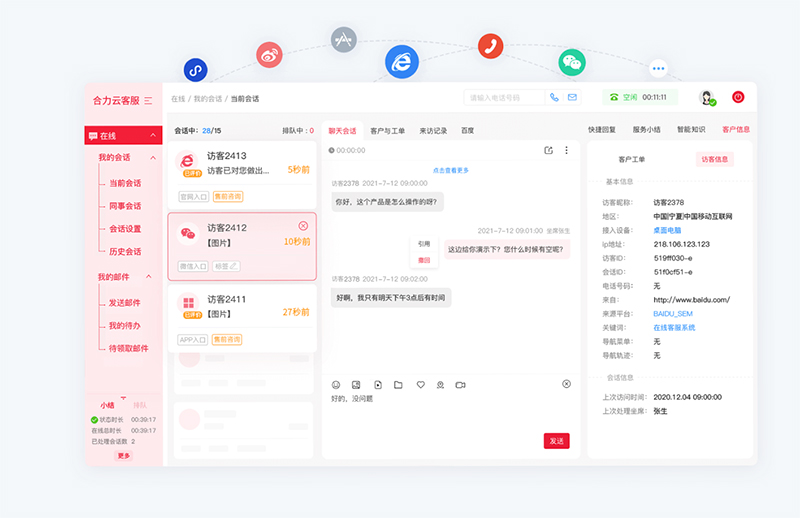

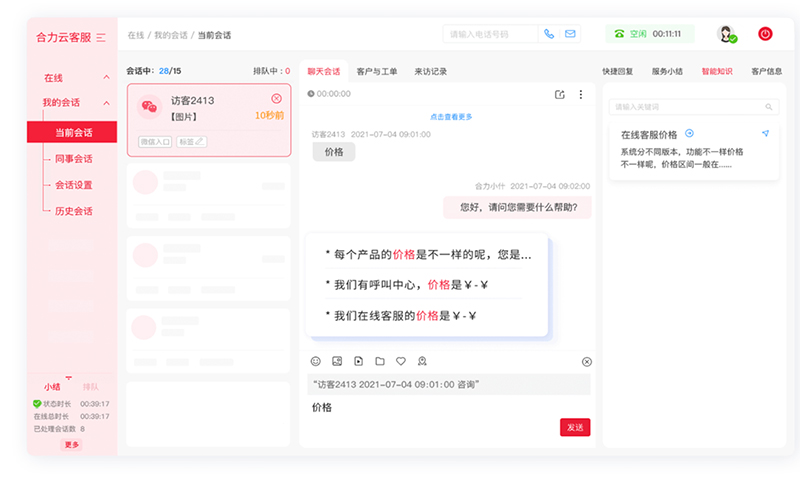

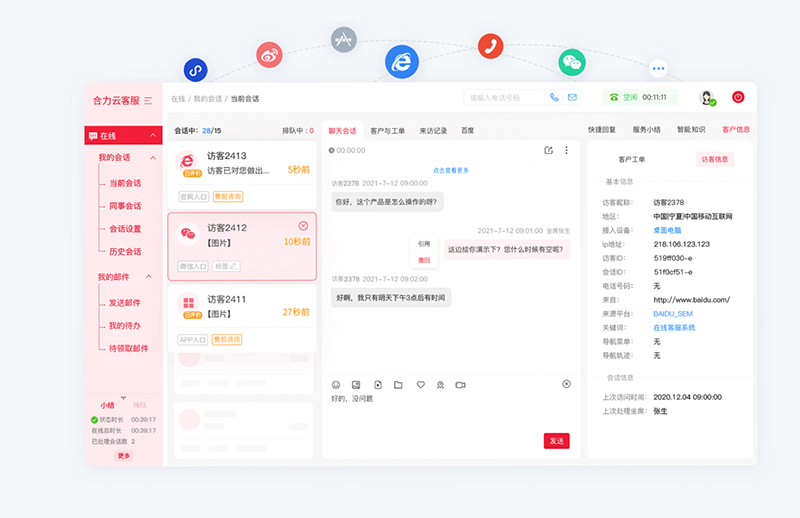

- 此时,应触发标准兜底话术:“此问题情况较为复杂,为确保准确性,建议您咨询人工窗口。” 同时,后台应依托亿捷云客服等专业的人机协同平台,将用户的历史对话上下文完整同步给人工坐席,实现从“智能拒识”到“人工接盘”的无缝软着陆,避免用户重复描述问题。

这看似降低了“智能化”程度,实则是对行政严谨性的最大敬畏。

五、 立即行动:政务大模型安全度“自检清单”

您的政务大模型项目是否正在“裸奔”?请项目负责人对照以下三个问题进行一次紧急自检。如果您对任何一个问题的回答是“否”或“不确定”,那么您的系统正处于高风险运行状态。

【政务大模型安全度·死亡三问】

1. 查信源: 你的机器人生成的每一句政策解读,是否都能让用户点击跳转到对应的红头文件原文条款?且该链接是否真实有效?

2. 查时效: 针对有“补充通知”或“修订函”的政策,你的知识库是否建立了关联索引?当旧文件与新补丁冲突时,机器人是否能优先引用最新的补丁条款?

3. 查兜底: 你是否测试过刁钻或极度模糊的问题?当系统拿不准时,它是诚实地转接人工,还是在自信地编造一个看起来很合理的错误答案?

六、 常见问题解答 (FAQ)

Q1:传统的关键词检索机器人已经很成熟了,为什么还需要冒风险上大模型? A:关键词匹配无法处理“多条件组合”(如:既是中小企业、又是软件行业、且纳税超50万)。大模型的核心价值在于其强大的语义理解与推理能力,能读懂复杂的政策逻辑。只要做好本文提到的风控措施,其服务效率与体验将远超传统机器人。

Q2:要实现“引用溯源”,需要对现有的政策文件做什么处理? A:不能直接上传PDF。必须进行“知识切片”与“结构化清洗”。将非结构化的红头文件,拆解为带有元数据(发布日期、生效状态、层级关系)的独立知识块。这是脏活累活,但也是政务大模型唯一的捷径。

Q3:开启“事实核查器”和“拒识机制”会不会让机器人显得很笨,回答很慢? A:事实核查通常在毫秒级完成,用户几乎无感。至于“拒识”,在政务场景下,“严谨的笨”优于“错误的聪明”。这不仅是体验问题,更是合规问题。

结语

政务大模型的落地,本质上不是一场技术竞赛,而是一场“数据治理”与“风控管理”的战役。只有先守住“不误导”的底线,才能谈“更智能”的上限。

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690