在如今的智能科技时代,大家有没有发现,很多智能设备都能和我们进行对话啦?就像我们和朋友聊天一样。这里面有个很关键的技术,就是多轮对话系统中的上下文管理。

一、什么是上下文管理?

简单来说,就是系统要能理解和记住我们之前说过的话,这样才能在后面的对话中给我们合适的回答。这就好比我们和朋友聊天,如果朋友能记住我们之前聊过的内容,那交流起来是不是就更顺畅啦?

二、上下文管理都有哪些方法?

1、上下文截断与重采样

有时候对话很长,模型可能记不住那么多内容,就像我们的记忆力也有限一样。所以对于长对话,早期的对话历史可能会被截断,信息就会丢失。

为了解决这个问题,就可以采用截断与重采样的方法。在生成回复前,把长对话截断,然后对截断后的对话进行重采样,这样就能增加多样性,让模型在回复时也能考虑到之前较早的对话内容。

2、上下文指示

为了让模型更清楚地知道哪些是相关的对话内容,我们可以在模型输入的最后添加一个特殊的标志来表示对话结束,或者用特殊的符号标记之前的对话历史。这样模型就能更好地理解上下文,回答也会更准确。

3、下文选择与加权

对于长时间的对话,模型可能没办法利用所有的上下文信息。这时候就需要上下文选择与加权啦。我们可以根据对话的重要性,选择对话历史中最相关、最重要的部分,然后用一些方法给它们加权,让模型用这些信息来生成回复,这样就能提高模型对上下文的利用效率。

4、上下文扩展与语义连接

为了避免回复时信息丢失或者误解,我们可以通过扩展上下文,引入其他相关的对话历史或者背景知识,让上下文更丰富,提供更多语义信息。同时,在生成回复时引用之前对话历史中的相关内容,保持回复的连贯性。

多轮对话系统中的上下文管理是个复杂的任务,涉及很多策略和技术。但是通过合理管理对话的上下文,就能提高模型回复的准确性和连贯性。随着科技的不断发展,这些技术也会越来越完善。

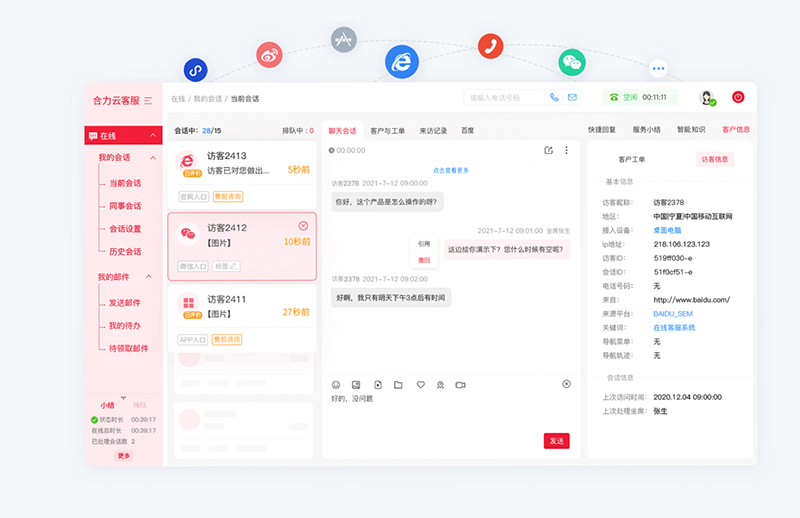

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690