AI客服在带来便利的同时,也像一把双刃剑——用户享受秒级响应的同时,总会担心聊天记录是否被滥用,个人信息会不会“裸奔”。如何在服务效率与伦理安全之间找到平衡点?咱们从三个核心矛盾切入,聊聊可落地的解决方案。

矛盾一:数据收集的“必要”与“过度”

AI客服需要数据训练才能理解用户需求,但采集哪些信息、存储多久,很容易踩过界。比如用户咨询退货政策时,系统是否必须获取家庭住址和身份证号?解决思路在于:

1. 分级分类管理:将数据分为“必须采集”(如订单号)、“可选采集”(如用户反馈)、“禁止采集”(如生物特征)三类。

2. 动态脱敏技术:对话中自动隐藏敏感信息,例如把手机号显示为“1381234”。

3. 数据保质期设定:非必要数据在对话结束后24小时内自动清除。

就像医院问诊只问病情不问存款,AI客服也该学会“不该问的别问,不该记的别记”。

矛盾二:安全防护的“铠甲”与“枷锁”

企业为了保护数据安全,常给AI客服层层加密,结果导致两种极端:要么系统反应迟钝影响体验,要么防护形同虚设。平衡的关键在于:

1. 轻量化验证机制:用设备指纹替代短信验证码,用户无感知完成身份核验。

2. 分权访问控制:普通客服只能看到对话文本,敏感信息需授权解密。

3. 对抗性训练:让AI学会识别钓鱼提问,例如遇到“你老板是谁”这类诱导性问题时自动终止对话。

安全措施不该让用户觉得“进自家门还要过安检”,而应像智能门锁——既守得住,又开得顺。

矛盾三:算法优化的“聪明”与“偏见”

AI客服在训练中可能吸收数据中的隐性偏见,例如对某些方言识别率低、对老年用户不够友好。某测试显示,当用户使用带口音的普通话提问时,AI的误解率比标准普通话高3倍。破局方法包括:

1. 多样性数据投喂:在训练库中加入不同年龄、地域、文化背景的语料。

2. 公平性监测指标:设置方言识别率、特殊需求响应准确率等考核维度。

3. 人工校正通道:当用户连续三次修正回答时,自动触发人工复核并修正算法。

就像裁判不能只熟悉一种运动规则,AI客服也该适应人类的多样性。

四个可落地的平衡策略

1. 透明化游戏规则

在对话开始时明确告知:“本次对话可能用于服务优化,您可随时要求删除记录”。

提供数据流向可视化工具,让用户看到信息如何被使用。

2. 把选择权还给用户

设置“隐私开关”:允许自主选择是否开启语音记录、位置信息等功能。

提供“对话粉碎机”:一键清除指定时间段的聊天记录。

3. 用技术对抗技术

联邦学习技术:让AI在不同终端分散学习,原始数据不出本地。

同态加密:在不解密数据的前提下完成模型训练。

4. 建立伦理审查机制

每季度对AI客服进行“道德压力测试”,例如故意输入诱导性问题检测应对是否合规。

设立用户权益代表岗位,参与算法优化决策。

结语:给技术装上“刹车灯”

AI伦理问题的解决没有终极答案,但可以确立三个基本原则:

1. 最小够用:数据采集止步于解决问题所需的最低限度。

2. 可逆控制:任何自动化决策都应保留人工干预入口。

3. 进化承诺:随着技术进步持续提升隐私保护强度。

隐私与安全的平衡不是选择题,而是动态调节的过程。就像汽车既要有油门提速,也得有刹车控速——AI客服的发展同样需要伦理框架护航。毕竟,让人安心享受科技便利的前提,是确信自己不会被技术“背刺”。

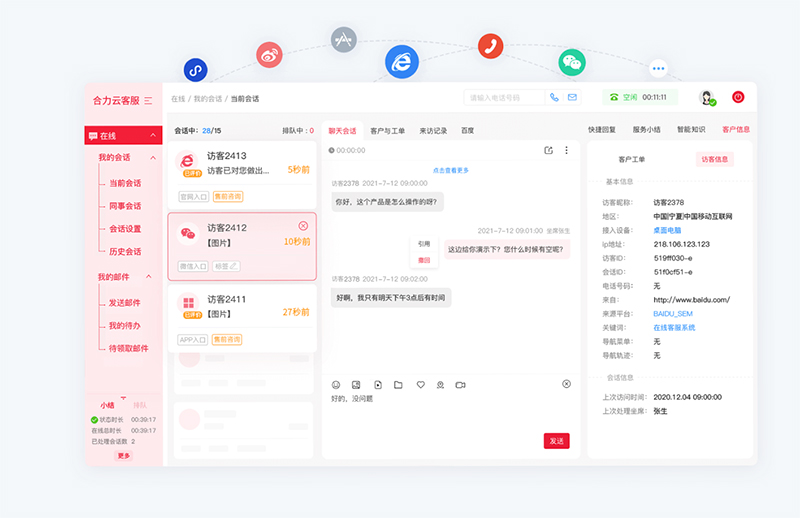

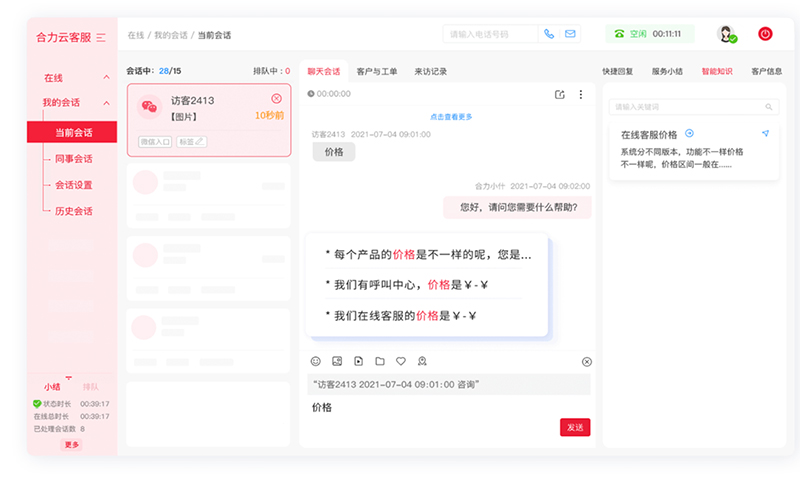

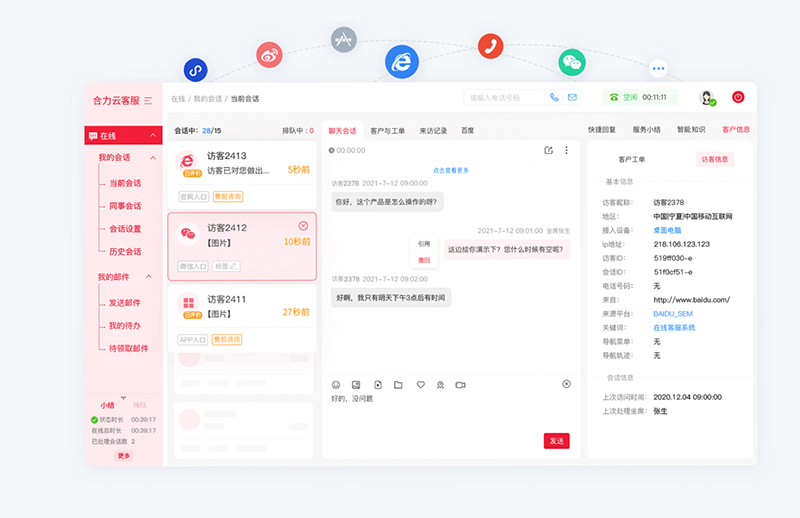

亿捷云客服基于AI大模型驱动智能客服机器人,集成了自然语言处理、语义理解、知识图谱、深度学习等多项智能交互技术,解决复杂场景任务处理,智能客服ai,精准语义理解,意图识别准确率高达90%。

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690