当你在嘈杂的地铁里对着手机说"我要改签机票",AI客服却能准确识别这句话时,背后正发生着一场声音的"解码革命"。从声波震动到文字转化,这个过程就像把海浪翻译成摩尔斯电码。今天,我们就来揭开语音转文本技术的神秘面纱。

一、语音识别的三大难关

1. 声音的混沌魔方

人类语音包含50-100种不同的声音特征,同一句话在不同场景下(如感冒时、吃饭时)的声波形态差异,比晴天与雨天的云层变化更复杂。

2. 环境的干扰战场

背景音乐、键盘敲击声、车辆鸣笛等噪音,就像在画布上泼洒的墨水,需要从混合声纹中精准剥离出有效语音。

3. 语言的百变戏法

口音差异("n""l"不分)、连读吞音("这样子"变成"酱子")、同音词选择("期中"与"期终"),给机器理解带来多重障碍。

二、语音转文本的四步解码术

1. 声波特征提取(耳朵模拟)

麦克风捕捉的原始声波像未显影的胶片。

通过梅尔频率倒谱系数(MFCC)技术,提取出音高、音强、共振峰等32维特征。

相当于把交响乐总谱拆解成单簧管、小提琴等乐器的分谱。

2. 声学模型识别(声音指纹比对)

深度神经网络充当"声音字典",将声音特征映射为音素(语音最小单位)。

使用长短时记忆网络(LSTM)捕捉语音的时序特征,就像用慢动作镜头分解快速对话。

方言语音会激活特定的神经元路径,实现"口音自适应"。

3. 语言模型纠偏(语义逻辑校验)

基于数十亿字语料训练的概率模型,像经验丰富的校对员。

当声学模型输出"我要改签鸡票",语言模型根据上下文修正为"机票"。

引入注意力机制(Attention)重点聚焦关键词汇,忽略无意义语气词。

4. 实时反馈优化(动态调适)

用户重复说"不对"时,系统自动降低当前识别结果的置信度。

通过说话人自适应技术(SAT),在对话过程中逐步适应用者独特的发音习惯。

如同翻译员在会议中越听越懂发言人的表达风格。

三、技术突破的关键节点

1. 端到端模型革新

传统流水线式处理(声学模型→发音模型→语言模型)正在被一体化神经网络取代,就像从手动挡汽车升级为自动驾驶。

2. 小样本学习能力

新型系统只需少量语音样本就能识别新语种,如同语言天才快速掌握方言。某开源模型已实现用1小时语音数据建立基础识别能力。

3. 多模态融合

结合唇部运动识别(视频)提升嘈杂环境下的准确率,当音频信号被施工噪音淹没时,视觉信息成为破译密码的"第二把钥匙"。

四、进化的未来图景

前沿研究正突破情感语音识别——不仅听懂字面意思,还能捕捉语气中的焦虑、兴奋等情绪特征。当用户说"挺好的"带着颤抖尾音时,系统能识别出潜在不满情绪。

更值得期待的是无间断实时翻译技术。设想这样的场景:用户用方言说"俄滴包裹莫见咧",系统先转换为普通话文本,再翻译成英文"my package is lost",整个过程延迟不超过0.8秒。

随着神经形态计算芯片的发展,语音识别能耗有望降低90%。这意味着未来智能手表也能运行现在需要服务器集群的识别模型,真正实现随时随地的自然对话。

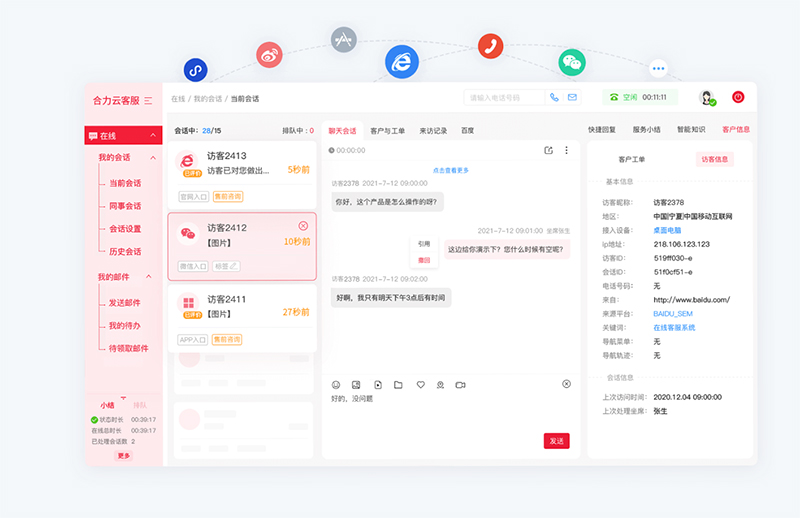

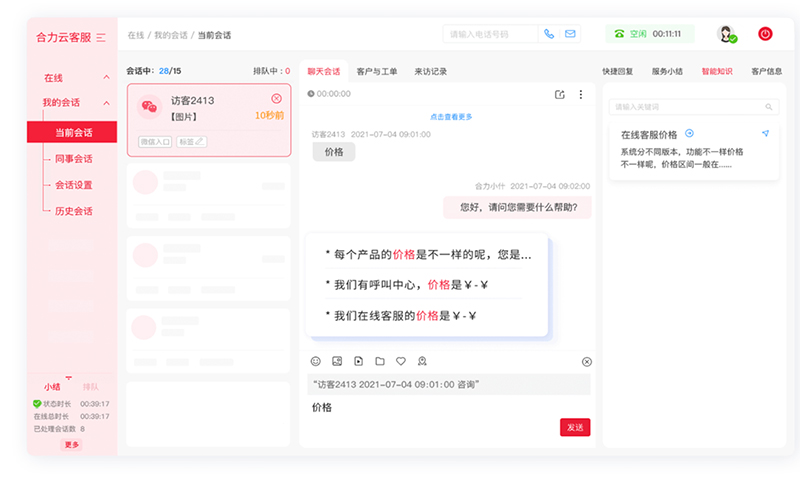

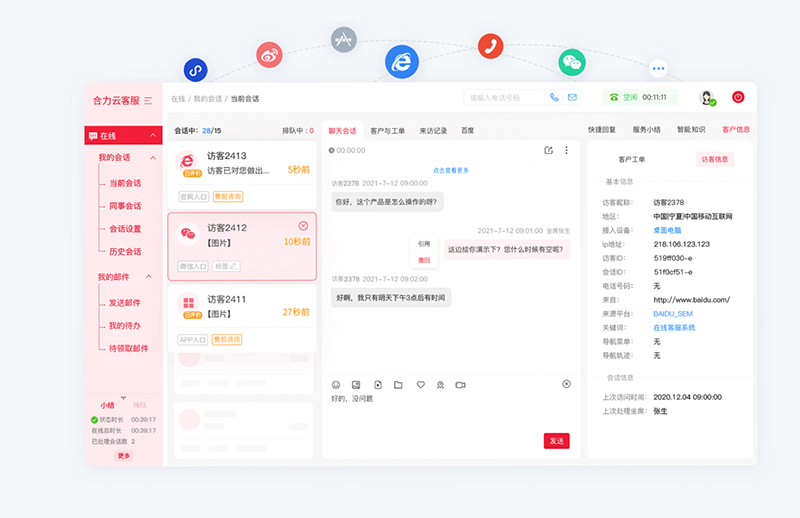

亿捷云客服基于AI大模型驱动智能客服机器人,集成了自然语言处理、语义理解、知识图谱、深度学习等多项智能交互技术,解决复杂场景任务处理,智能客服ai,精准语义理解,意图识别准确率高达90%。

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690