你是否遇到过和AI客服对话时,对方“反应迟钝”的情况?明明只是问了一个简单问题,却要等上好几秒才能得到回应。这种“卡顿”背后,其实是多种因素共同作用的结果。今天我们就来聊聊影响对话式AI客服响应速度的关键因素,以及如何通过优化提升它的“反应能力”。

一、响应速度被谁“拖后腿”?

1. 硬件配置:算力不足的“体力透支”

服务器的CPU、内存、GPU等硬件资源就像AI的“体能储备”。当用户请求量激增时,低配服务器容易“体力不支”,导致任务排队等待处理。比如春节期间大量用户咨询的场景,算力不足的AI系统可能直接“喘不过气”。

2. 网络延迟:数据传递的“堵车路段”

用户请求从手机到服务器要经过多个网络节点,任何一环出现延迟(比如跨地域传输、带宽不足)都会拖慢整体速度。这就好比快递包裹在高速公路上遇到堵车,再快的处理速度也得干等着。

3. 算法复杂度:模型越聪明,思考越费时?

大型语言模型虽然能理解复杂问题,但动辄几十亿参数的计算需要消耗更多时间。就像一个学霸解题,题目越难,他思考的时间就越长。

4. 数据处理:信息消化的“肠胃负担”

AI需要实时解析用户意图、检索知识库、生成回答,这些步骤就像消化食物的过程。如果知识库结构混乱、数据量庞大,或者意图识别模型不够精准,都会延长处理时间。

5. 并发请求:早高峰的“地铁困境”

当数千人同时提问时,系统可能像早高峰地铁站一样拥挤。即使单个请求处理很快,资源分配不当也会导致部分用户“挤不上车”。

二、如何让AI客服“快如闪电”?

1. 硬件升级:给AI装上“强心脏”

采用高性能服务器集群,像给汽车换装V8发动机。

使用负载均衡技术,把用户请求“分流”到不同服务器。

对GPU资源做定向优化,加速模型推理速度。

2. 网络优化:修建信息高速公路

通过CDN节点就近部署,让数据传输少“绕远路”。

采用专线网络降低延迟,相当于给数据包开“绿色通道”。

压缩传输数据体积,像把大件行李换成随身小包。

3. 算法瘦身:既要聪明也要敏捷

使用模型蒸馏技术,把“教授级大模型”精简成“实战型小模型”。

采用缓存机制,对高频问题“秒回”预制答案。

实现意图识别与答案生成并行处理,像餐厅前厅接单和后厨炒菜同时进行。

4. 架构设计:打造弹性响应系统

引入分布式架构,像增加收银台应对客流高峰。

设置自动扩缩容策略,请求量突增时自动“召唤增援”。

采用异步处理机制,把耗时任务放到后台“悄悄完成”。

5. 持续调优:AI也需要“体检报告”

建立实时监控看板,像汽车仪表盘一样显示系统状态。

定期进行压力测试,提前发现“隐形瓶颈”。

通过A/B测试对比优化效果,用数据说话。

三、速度与质量的平衡之道

提升响应速度绝非单纯“求快”,更需要兼顾准确性。就像短跑运动员不能只顾冲刺不管姿势,AI优化时要注意:

避免过度压缩模型导致“降智”。

缓存策略需动态更新,防止答案“过期”。

在复杂问题场景保留人工兜底机制。

未来,随着边缘计算、量子计算等技术的发展,AI客服的响应速度将进入“毫秒级”时代。但技术优化的本质从未改变——用更聪明的架构设计,让机器更好地服务于人。

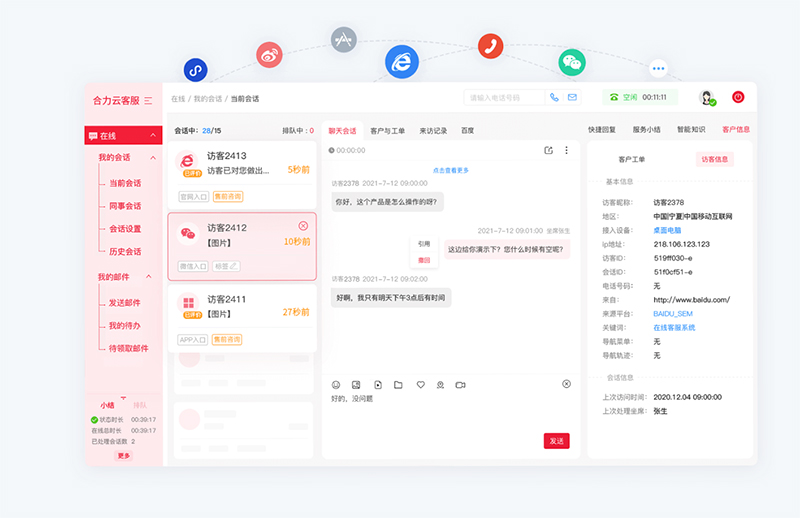

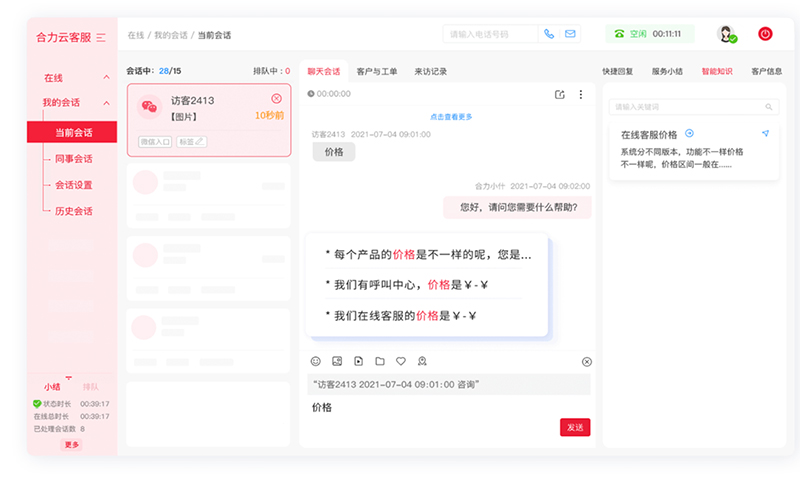

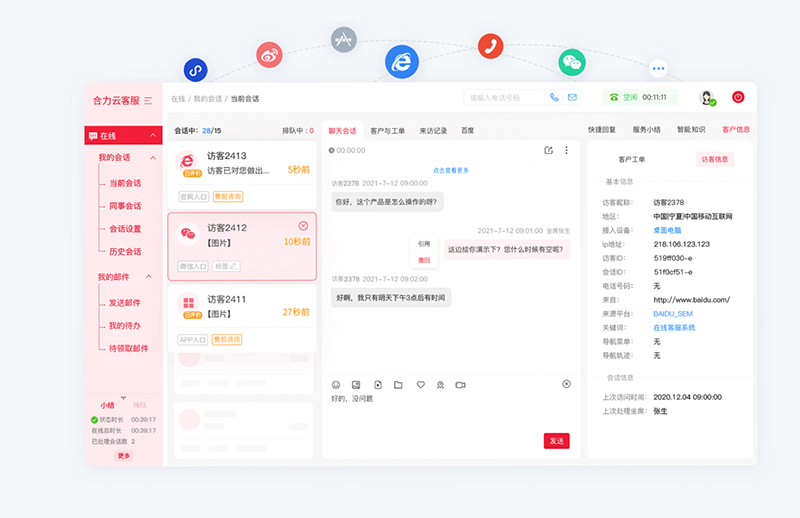

亿捷云客服基于AI大模型驱动智能客服机器人,集成了自然语言处理、语义理解、知识图谱、深度学习等多项智能交互技术,解决复杂场景任务处理,智能客服ai,精准语义理解,意图识别准确率高达90%。

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690