在人工智能技术加速落地的当下,LLM(大语言模型)驱动的客服系统正成为企业与用户交互的核心枢纽。其准确性直接决定了客户体验的满意度、服务效率的提升空间以及企业品牌形象的塑造能力。

然而,由于自然语言理解的复杂性、上下文场景的多变性以及知识更新的动态性,大语言模型客服在落地过程中常面临语义误解、信息偏差、逻辑断层等风险。如何在技术层面系统性提升应答准确性,成为释放大语言模型客服潜力的关键命题。本文将从算法优化的视角,解析保障模型可靠性的核心机制与实现路径。

一、LLM大语言模型在客服领域的应用现状

大语言模型客服的普及源于其两大核心优势:通用语言理解能力与动态生成效率。与传统规则型或检索型客服系统不同,大语言模型客服无需依赖人工预设的问答模板,而是通过预训练获得对自然语言的抽象理解能力,能够覆盖更广泛的用户提问形式。

然而,这种技术路径也引入了新的挑战。一方面,大语言模型的“幻觉”现象可能导致脱离实际的回答;另一方面,垂直领域的专业知识缺失可能降低应答的专业性。例如,在医疗、金融等强合规领域,模型若未经针对性优化,容易生成误导性内容。因此,提升大语言模型客服的准确性,既需要克服通用模型的固有缺陷,也要解决场景化落地的适配难题。

当前主流的技术路线通常采用“预训练+微调+强化学习”的三阶段框架,基础模型通过海量公开数据获得语言理解能力,再使用企业私有数据进行领域适配,最终通过用户反馈数据优化生成策略。这一流程的核心目标在于平衡模型的通用性与专业性,但其效果高度依赖算法优化的精细程度。

二、LLM大语言模型驱动客服准确性的保障措施

保障大语言模型客服的准确性需构建多层次的技术防护体系,涵盖数据治理、模型训练、系统架构等多个环节:

1. 数据质量的闭环管控

输入净化:通过敏感词过滤、语法纠错、意图预判等模块,对用户原始输入进行清洗,减少噪声数据对模型推理的干扰。

知识库增强:将企业结构化知识(如产品手册、政策文件)转化为向量化索引,与模型生成结果实时比对,确保输出内容与官方信息一致。

反馈回流机制:将用户对回答的满意度评分、人工修正记录等数据回流至训练集,持续迭代模型表现。

2. 模型能力的定向强化

领域自适应训练:在通用模型基础上,使用垂直领域语料进行增量训练,提升专业术语识别与行业知识应用能力。

拒绝机制设计:当模型置信度低于阈值时,自动触发转人工或标准话术应答,避免“强行回答”导致的错误扩散。

多模型协同校验:采用异构模型交叉验证策略,例如结合生成式模型与判别式模型,对输出内容进行一致性检查。

3. 系统架构的稳定性设计

实时监控与熔断:部署响应延迟、错误率、异常流量等监控指标,在检测到性能下降时自动切换至备用模型或降级方案。

版本灰度发布:新模型上线前通过AB测试验证效果,逐步扩大流量占比,最大限度控制潜在风险的影响范围。

这些措施共同构成了大语言模型客服的准确性保障基线,但其核心驱动力仍在于算法层面的持续优化。

三、3大算法优化机制揭秘

要突破大语言模型客服的准确性瓶颈,需从算法设计层面解决三个关键问题:上下文理解偏差、知识实时性不足、错误传播不可控。对应地,行业实践中形成了三大核心优化机制:

1. 上下文感知增强机制

该机制旨在提升模型对长对话历史与隐性语义的捕捉能力,具体通过以下技术实现:

分层注意力优化:在Transformer架构中引入局部注意力与全局注意力的混合机制,前者聚焦当前对话片段,后者关联历史关键节点(如用户身份信息、问题核心诉求),避免长程依赖导致的注意力稀释。

对话状态跟踪:将多轮交互信息编码为动态更新的对话状态向量,作为生成回答的上下文锚点。例如,当用户连续询问“运费多少”“是否包邮”时,系统自动标记“运费政策”为对话焦点,确保后续回答不偏离主题。

歧义消解模块:通过对比学习策略训练模型识别语义模糊点,在检测到潜在歧义时主动发起澄清提问(如“您指的是2023款还是2024款产品?”),而非基于概率猜测生成回答。

2. 动态知识蒸馏机制

针对大语言模型客服的知识滞后问题,该机制实现了外部知识与模型参数的协同更新:

实时检索增强生成(RAG):将用户问题与最新知识库进行向量相似度匹配,抽取相关片段作为生成答案的参考依据。例如,当政策文件更新后,系统优先基于检索结果生成回答,而非依赖模型记忆中的过期信息。

增量知识蒸馏:定期将新增知识(如产品更新日志、客服QA记录)转化为轻量级适配层参数,通过知识蒸馏技术注入主模型,避免全量重训练带来的高成本。

时效性置信度评估:为每个知识条目附加时间戳与版本号,当问题涉及时效敏感内容时,自动校验知识库版本并优先采用最新数据。

3. 多阶段纠错机制

该机制通过生成前、生成中、生成后三阶段的交叉验证,阻断错误传递链条:

生成前约束引导:在解码阶段引入逻辑规则约束,例如强制关联企业知识图谱中的实体关系,防止生成违反业务逻辑的表述(如将“保修期三年”误写为“保修期三个月”)。

生成中自检修正:采用自回归生成与反向验证并行的策略,模型在输出每个词元时同步进行合理性评估,当检测到矛盾点时回滚至最近可靠节点重新生成。

生成后多模校验:对最终回答进行事实性校验(如数值准确性检查)、合规性校验(如敏感词过滤)、逻辑一致性校验(如与用户问题的因果关联度分析),未通过校验的回答触发重新生成或人工审核流程。

总结:

大语言模型客服的准确性优化是一场持续的技术马拉松。三大算法机制——上下文感知增强、动态知识蒸馏、多阶段纠错——共同构筑了当前阶段的核心防御体系,但它们并非静态的终极方案。随着用户需求复杂度的提升与行业知识的快速迭代,算法优化需进一步向细粒度控制、实时性响应、可解释性验证等维度延伸。

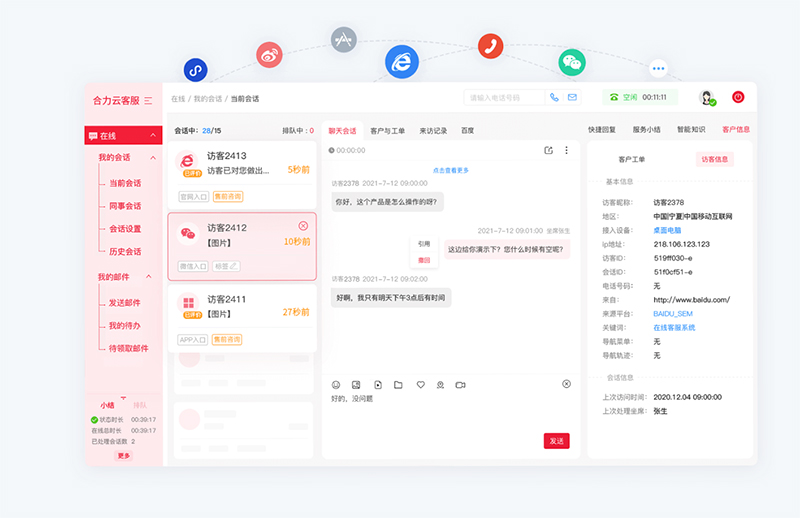

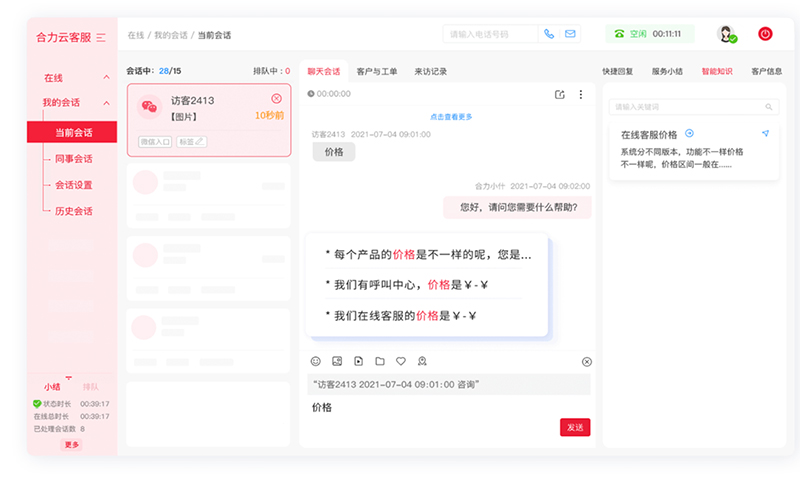

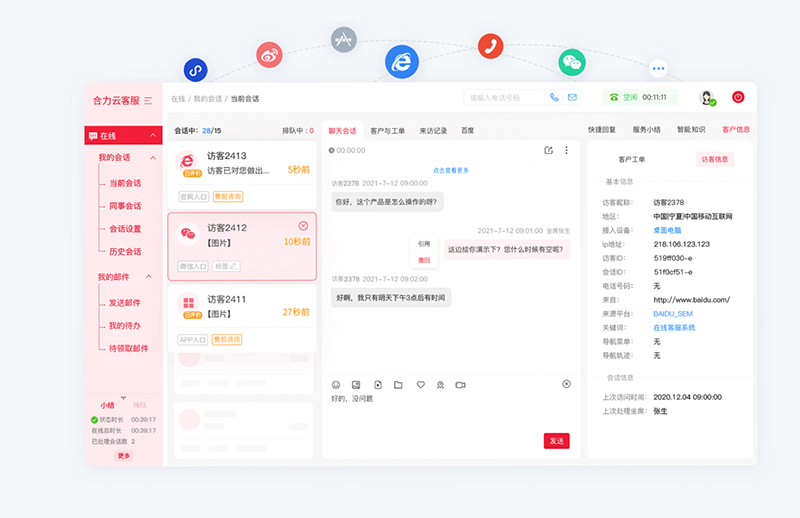

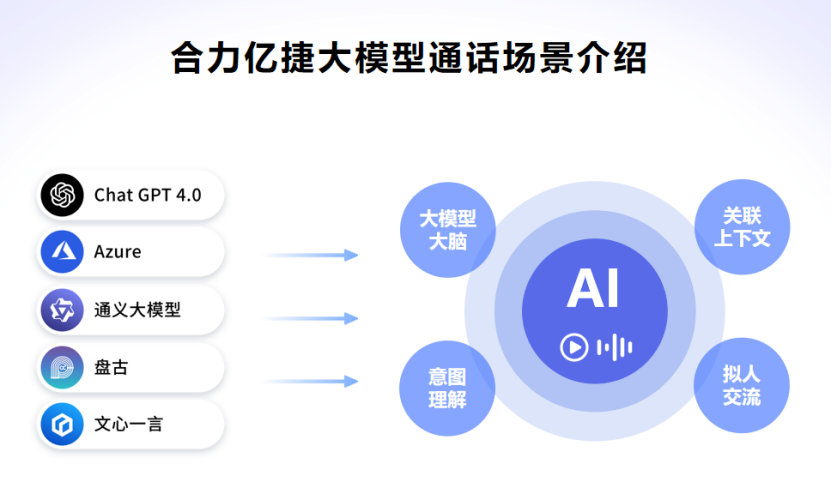

亿捷云客服基于AI大模型驱动智能客服机器人,集成了自然语言处理、语义理解、知识图谱、深度学习等多项智能交互技术,解决复杂场景任务处理,智能客服ai,精准语义理解,意图识别准确率高达90%。

如需智能客服、AI客服机器人产品,请联系【亿捷云客服】,联系电话: 4006-345-690